Actualidad

1.000 Starships y 20 años de lanzamientos

SpaceX instaló el año pasado un letrero luminoso en Starbase que dice “Gateway to Mars” (puerta de acceso a Marte). Elon Musk fundó la compañía en 2002 con el dinero de la venta de PayPal y la determinación de colonizar el planeta rojo. SpaceX ha conseguido cosas increíbles desde entonces, pero su plan más optimista requerirá al menos mil Starships y otros 20 años de trabajo, según el propio Musk.

Antes de fundar SpaceX, Elon Musk pasó brevemente por la junta directiva de la Mars Society, una organización sin ánimo de lucro que promueve la conquista humana de Marte.

Fue en una charla plenaria de la asociación donde Musk anunció un proyecto llamado Mars Oasis que pretendía instalar un pequeño invernadero en el planeta rojo para reactivar el interés público en la exploración marciana.

Musk es ambicioso, y la idea de cultivar plantas en Marte acabó evolucionando en algo mucho más complejo: convertir a la humanidad en una especie multiplanetaria que pueda sobrevivir a una catástrofe en la Tierra. O visto de un modo más pragmático, crear la arquitectura necesaria para un asentamiento humano autosostenible en Marte.

“Un momento, podría crear mis propios cohetes para ir a Marte”, debió pensar Musk, porque 20 años más tarde eso es exactamente lo que está haciendo con la Starship.

Mil Starships para colonizar Marte

Aunque su nombre y diseño han cambiado con los años, el plan a largo plazo del programa Starship sigue siendo el mismo:

- Un cohete enorme, total y rápidamente reutilizable, que pueda lanzar más de 100 toneladas al espacio con un coste mínimo

- Una flota de estos cohetes, financiada con fondos públicos y privados, que pueda transportar a decenas de personas al planeta rojo para construir allí una base tripulada

- Miles de estos cohetes volando a Marte cada vez que los planetas estén alineados para construir una ciudad autosuficiente de un millón de habitantes

SpaceX todavía tiene que demostrar el primer punto, pero además de ambicioso, Musk es optimista. En 2019, el magnate estimó que harían falta mil Starships y 20 años de lanzamientos para construir una ciudad sostenible en el planeta rojo.

Además, cifró el coste de cada lanzamiento en 2 millones de dólares, una cantidad absurdamente baja para los estándares de la industria. Lanzar un Falcon Heavy, el cohete más potente en servicio, cuesta 50 veces más.

En 2020, Musk arrojó algunos cálculos adicionales. El objetivo de Starship es volar tres veces al día, mil veces al año, lanzando un megatón anual al espacio por cada diez Starships. “Si construimos 100 Starships al año, obtendremos 1000 en 10 años, o 100 megatones al año”, dijo. “Aproximadamente 100.000 personas por cada sincronización orbital Tierra-Marte”.

Las ventanas de lanzamiento a Marte se abren cada 26 meses aprovechando que se encuentra más cerca de la Tierra. Musk cree que, si los lanzamientos comenzaran en 2028, la ciudad marciana de un millón de habitantes podría materializarse apenas 22 años más tarde, en 2050.

Es una visión sumamente optimista de lo que una empresa como SpaceX puede hacer en tan corto plazo, pero hay algo que no se puede negar de Elon Musk: su objetivo lleva siendo el mismo desde que fundó SpaceX. La empresa vale ahora 180.000 millones de dólares y la Starship existe, la hemos visto llegar al espacio.

Imagen | SpaceX

En Xataka | El tamaño descomunal de Starship, en imágenes que dan una idea de su escala

*Una versión anterior de este artículo se publicó en diciembre de 2023

ues de anuncios individuales.

Source link

Actualidad

Con el segmento de consumo ahogándose, Samsung es la primera en fabricar memoria HBM4. Y será para NVIDIA, claro

Samsung es uno de los nombres propios de este febrero. Se espera que presenten los Galaxy S26, pero tienen bajo la mesa algo que será un revulsivo no sólo para sus arcas, sino para el motor de la economía de Corea del Sur. Nos referimos a las memorias de alto ancho de banda porque, en plena crisis de la RAM y los SSD, Samsung está preparada para fabricar en masa las memorias HBM4.

Y será para la IA, cómo no podía ser de otra forma.

En corto. La compañía surcoreana no lo ha confirmado, pero informes recientes publicados por Reuters y fuentes locales como el Korea JoongAng Daily apuntan que Samsung comenzará a fabricar en masa los chips de memoria HBM4 a partir de la próxima semana.

Será la primera de las tres empresas que dominan la producción de chips de memoria (las otras son la surcoreana SK Hynix y la estadounidense Micron, la que se ha ido de la RAM de consumo) en empezar a fabricar en grandes cantidades estas memorias fundamentales para la inteligencia artificial.

HBM4. Este tipo de memoria, como su nombre indica, cuenta con un enorme ancho de banda. Esto es crucial para las necesidades de la GPU y, aunque NVIDIA se ha mantenido fiel a la memoria GDDR para sus tarjetas gráficas, AMD sí coqueteó con la tecnología apilada de los chips HBM para sus GPU Vega. Sin embargo, no es una tecnología para consumo no porque sus prestaciones no sean adecuadas, sino porque es demasiado caro.

Hacer memoria HBM es más costoso que fabricar chips DRAM tradicionales, pero las ventajas están ahí. Con HBM4, por ejemplo, la densidad de los chips apilados permite el doble de ancho de banda que en la generación anterior. Esto es clave para transmitir más datos por segundo, pero además consumen hasta un 40% menos de energía que las memorias HBM3.

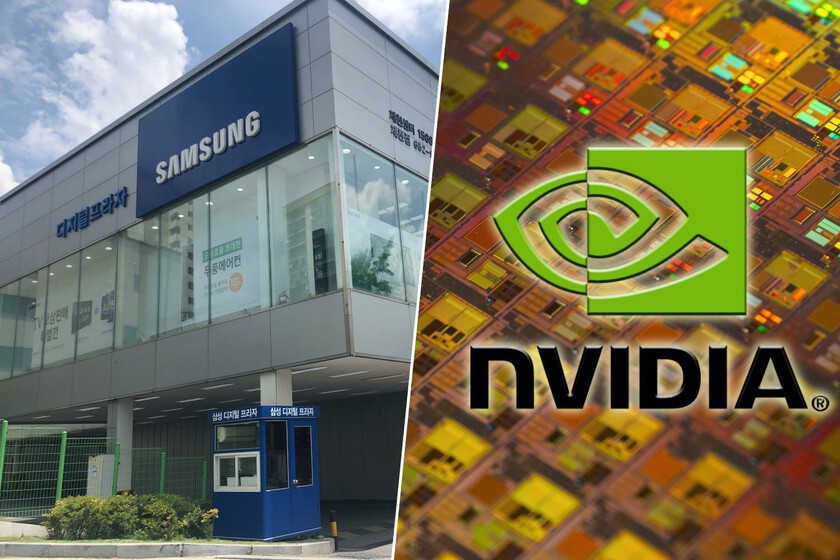

NVIDIA. La máxima interesada es, como hemos contado en anteriores ocasiones, NVIDIA. Y si NVIDIA es beneficiada, prácticamente toda la industria puntera de la inteligencia artificial se aprovechará de ello debido a que sus chips son los que están moviendo la industria actualmente. Se estima que las memorias de Samsung irán a parar a los sistemas de aceleración Vera Rubin de NVIDIA

De hecho, se ha reportado que el propio Jensen Huang ha instado a acelerar y aumentar la producción de estos chips. Bueno, Huang ha pedido a toda la industria de semiconductores que manufacturan componentes de sus tarjetas que se pongan las pilas, no es algo que ataña sólo a Samsung.

Punta de lanza. Según una fuente del Korea KoongAng Daily, “Samsung es la que tiene la mayor capacidad de producción del mundo y la línea de productos más amplia. Ha demostrado una recuperación en su competitividad tecnológica al convertirse en la primera en producir en masa la memoria HBM4 de mayor rendimiento”.

Porque, en este campo, se espera que su máxima competidora, la vecina SK Hynix, empiece a fabricar en masa su respuesta entre marzo o abril, tiempo de ventaja suficiente para que Samsung empiece a enviar su memoria a NVIDIA. Y, aquí, la gran ventaja de Samsung es que no depende de TSMC: tiene su propia fundición y los módulos HBM4 están basados en una fotolitografía de 4 nanómetros.

Mirando al futuro. El retraso de SK Hynix no es porque se hayan dormido en los laureles: son los que llevan la batuta en la anterior generación gracias a la memoria HBM3E, pero debido a su cronograma y a que no lo necesitaban, empezaron a desarrollar la nueva generación más tarde que Samsung. Pero claro, aunque HBM sea el estándar en sistemas de IA actuales, ya hemos dicho que son chips caros y, además, se calientan una barbaridad, necesitando equipos de disipación a la altura.

Y ahí es donde las empresas están combinando la producción de memoria HBM4 con una nueva generación de memoria DRAM. La idea es encontrar una manera de que esta memoria -más lenta, pero barata y ‘fresca’- pueda competir en ancho de banda con la HBM. Samsung y SK Hynix están en ello, pero tendrán que competir contra alguien que no jugaba en esta liga: una Intel que no llega sola, sino de la mano del gigante japonés SoftBank.

En definitiva: Samsung se ha propuesto volver por sus fueros en lo que a músculo manufacturero se refiere. Y lo más importante de todo es que todas las empresas que hacen módulos de memoria siguen centradas en una cosa: hace hardware para la inteligencia artificial mientras componentes como la RAM y SSD de consumo tienen los precios por la estratosfera.

Imágenes | Maxence Pira, Choi Kwang-mo, logo de NVIDIA (editada)

ues de anuncios individuales.

Source link

Actualidad

Con el segmento de consumo ahogándose, Samsung es la primera en fabricar memoria HBM4. Y será para NVIDIA, claro

Samsung es uno de los nombres propios de este febrero. Se espera que presenten los Galaxy S26, pero tienen bajo la mesa algo que será un revulsivo no sólo para sus arcas, sino para el motor de la economía de Corea del Sur. Nos referimos a las memorias de alto ancho de banda porque, en plena crisis de la RAM y los SSD, Samsung está preparada para fabricar en masa las memorias HBM4.

Y será para la IA, cómo no podía ser de otra forma.

En corto. La compañía surcoreana no lo ha confirmado, pero informes recientes publicados por Reuters y fuentes locales como el Korea JoongAng Daily apuntan que Samsung comenzará a fabricar en masa los chips de memoria HBM4 a partir de la próxima semana.

Será la primera de las tres empresas que dominan la producción de chips de memoria (las otras son la surcoreana SK Hynix y la estadounidense Micron, la que se ha ido de la RAM de consumo) en empezar a fabricar en grandes cantidades estas memorias fundamentales para la inteligencia artificial.

HBM4. Este tipo de memoria, como su nombre indica, cuenta con un enorme ancho de banda. Esto es crucial para las necesidades de la GPU y, aunque NVIDIA se ha mantenido fiel a la memoria GDDR para sus tarjetas gráficas, AMD sí coqueteó con la tecnología apilada de los chips HBM para sus GPU Vega. Sin embargo, no es una tecnología para consumo no porque sus prestaciones no sean adecuadas, sino porque es demasiado caro.

Hacer memoria HBM es más costoso que fabricar chips DRAM tradicionales, pero las ventajas están ahí. Con HBM4, por ejemplo, la densidad de los chips apilados permite el doble de ancho de banda que en la generación anterior. Esto es clave para transmitir más datos por segundo, pero además consumen hasta un 40% menos de energía que las memorias HBM3.

NVIDIA. La máxima interesada es, como hemos contado en anteriores ocasiones, NVIDIA. Y si NVIDIA es beneficiada, prácticamente toda la industria puntera de la inteligencia artificial se aprovechará de ello debido a que sus chips son los que están moviendo la industria actualmente. Se estima que las memorias de Samsung irán a parar a los sistemas de aceleración Vera Rubin de NVIDIA

De hecho, se ha reportado que el propio Jensen Huang ha instado a acelerar y aumentar la producción de estos chips. Bueno, Huang ha pedido a toda la industria de semiconductores que manufacturan componentes de sus tarjetas que se pongan las pilas, no es algo que ataña sólo a Samsung.

Punta de lanza. Según una fuente del Korea KoongAng Daily, “Samsung es la que tiene la mayor capacidad de producción del mundo y la línea de productos más amplia. Ha demostrado una recuperación en su competitividad tecnológica al convertirse en la primera en producir en masa la memoria HBM4 de mayor rendimiento”.

Porque, en este campo, se espera que su máxima competidora, la vecina SK Hynix, empiece a fabricar en masa su respuesta entre marzo o abril, tiempo de ventaja suficiente para que Samsung empiece a enviar su memoria a NVIDIA. Y, aquí, la gran ventaja de Samsung es que no depende de TSMC: tiene su propia fundición y los módulos HBM4 están basados en una fotolitografía de 4 nanómetros.

Mirando al futuro. El retraso de SK Hynix no es porque se hayan dormido en los laureles: son los que llevan la batuta en la anterior generación gracias a la memoria HBM3E, pero debido a su cronograma y a que no lo necesitaban, empezaron a desarrollar la nueva generación más tarde que Samsung. Pero claro, aunque HBM sea el estándar en sistemas de IA actuales, ya hemos dicho que son chips caros y, además, se calientan una barbaridad, necesitando equipos de disipación a la altura.

Y ahí es donde las empresas están combinando la producción de memoria HBM4 con una nueva generación de memoria DRAM. La idea es encontrar una manera de que esta memoria -más lenta, pero barata y ‘fresca’- pueda competir en ancho de banda con la HBM. Samsung y SK Hynix están en ello, pero tendrán que competir contra alguien que no jugaba en esta liga: una Intel que no llega sola, sino de la mano del gigante japonés SoftBank.

En definitiva: Samsung se ha propuesto volver por sus fueros en lo que a músculo manufacturero se refiere. Y lo más importante de todo es que todas las empresas que hacen módulos de memoria siguen centradas en una cosa: hace hardware para la inteligencia artificial mientras componentes como la RAM y SSD de consumo tienen los precios por la estratosfera.

Imágenes | Maxence Pira, Choi Kwang-mo, logo de NVIDIA (editada)

ues de anuncios individuales.

Source link

Actualidad

estudiar humanidades será más importante que nunca

Cuando un estudiante se encuentra a las puertas de la PAU (Prueba de Acceso a la Universidad) y se plantea qué estudios iniciar si quiere dedicarse al desarrollo de la IA, es probable que opte por una ingeniería informática o alguna carrera STEM. En cierto modo sería la decisión correcta y prueba de ello son las altas tasas de inserción laboral que, año tras año, marcan las ingenierías técnicas.

Sin embargo, según Daniela Amodei, cofundadora y presidenta de Anthropic, las humanidades son la clave para el futuro laboral con la IA. Para programar ya está Claude.

Menos máquina, más humanas. En una reciente entrevista concedida a ABC News, Daniela Amodei, licenciada en Literatura por la Universidad de California en Santa Cruz y hermana del también cofundador de Anthropic, Dario Amodei, defiende que “estudiar humanidades va a ser más importante que nunca”.

Su argumento se sostiene en el mismo discurso que desde hace algún tiempo sustentan otros directivos de la IA como Jensen Huang: “nuestro trabajo es crear tecnología informática para que nadie necesite programar”, aseguraba Huang en una conferencia en 2024.

“Muchos de estos modelos son en realidad muy buenos en STEM, ¿verdad? Pero creo que esta idea de que hay cosas que nos hacen únicos como humanos, entendernos a nosotros mismos, entender la historia, entender qué nos motiva, eso siempre va a ser realmente importante”. Es decir, lo que Amodei considera que va a ser realmente valioso en el futuro no son personas que sepan programar, sino que enseñen a los modelos de IA a pensar como un humano.

En Anthropic ya están en ese camino. La presidenta de Anthropic, aseguraba que a la hora de contratar a nuevos empleados, ya priorizan perfiles de “grandes comunicadores, que tengan un excelente coeficiente emocional y habilidades con las personas, que sean amables, compasivos y curiosos y quieran ayudar a los demás”. Para la directiva, “las cosas que nos hacen humanos se volverán mucho más importantes en lugar de mucho menos importantes”.

De hecho, Amodei no ve el futuro del trabajo como un escenario de humano contra IA, sino de humanos más IA. “La combinación de humanos e IA crea trabajos más significativos, más desafiantes, más interesantes y de alta productividad”, subrayaba la presidenta de Anthropic, “Y creo que también abrirá la puerta a un mayor acceso y oportunidades para muchas personas”, apostilló.

La cruda realidad laboral en España. La tasa de inserción laboral de la rama de humanidades en España pinta otro panorama muy diferente. Según datos de la Fundación BBVA y el Ivie, el 77,6% de jóvenes universitarios logra un empleo acorde a su titulación. Los estudiantes que cursan ingenierías informáticas y de software obtienen una tasa de empleabilidad media del 89,4%.

En cambio, según el informe ‘La empleabilidad de los jóvenes en España 2025’ de la Fundación Conocimiento y Desarrollo (CYD), la rama de Arte y Humanidades son las que menos salidas profesionales ofrecen con una tasa de afiliación media del 63,5%.

Un presente complicado. Amodei prevé un futuro muy distinto en el que la IA liberará lo técnico para potenciar lo humano. Pero lo cierto es que en la actualidad los graduados en Artes y Humanidades son los que peores salarios tienen.

Solo el 36,4% de los graduados en ramas de humanidades supera los 1.500 euros mensuales, frente a las ingenierías que cobran una media de 2.900 euros brutos anuales.

Imagen | Anthropic, Unsplash (Tai Bui)

ues de anuncios individuales.

Source link

-

Actualidad1 día ago

Actualidad1 día agola Grokipedia de Elon Musk

-

Actualidad1 día ago

Actualidad1 día agola Grokipedia de Elon Musk

-

Actualidad2 días ago

Actualidad2 días agoEn Tokio hay una librería con solo un libro en el catálogo. Lleva diez años abierta y funciona

-

Deportes2 días ago

Deportes2 días agoEl FC Barcelona se desvinculó oficialmente de la Superliga

-

Actualidad21 horas ago

Actualidad21 horas agoMiles de personas se cambian de ropa nada más del trabajo. La neurociencia tiene algo que decir: llevan razón

-

Deportes2 días ago

El FC Barcelona se desvinculó oficialmente de la Superliga

-

Actualidad2 días ago

Actualidad2 días agoHay gente capaz de dar positivo en un control de alcoholemia sin haber bebido una gota de alcohol. Y ya sabemos por qué

-

Actualidad1 día ago

Actualidad1 día agohoy sigue dominando Sri Lanka