Actualidad

El regalo perfecto para fans de Marvel es este set de LEGO con el que recrear el escudo del Capitán América

Si vas a regalarle algo en Reyes a un fan de Marvel y que, a la vez, es de LEGO, este set de LEGO del escudo del Capitán América es una buena opción a tener en cuenta. Agotado en la web oficial de la compañía, ahora en MediaMarkt, puedes conseguirlo más barato, ya que está disponible hasta mañana, por 169,99 euros.

* Algún precio puede haber cambiado desde la última revisión

Un set de LEGO con más de 3.000 bloques y una minifigura

Sin duda, el escudo del Capitán América es uno de los símbolos más icónicos de Marvel. Ahora, gracias a este set de LEGO lo podrá tener en casa cualquier fan de la división de superhéroes y colocarlo en algún rincón o estantería como una pieza de adorno ideal.

Este set está formado por 3.128 bloques y es recomendado para mayores de 18 años. Viene con una base con placa de identificación, además de con una minifigura del Capitán América. Terminado, el modelo mide aproximadamente 47 cm de diámetro.

Además, si te descargas la app LEGO Builder, podrás interactuar con esta construcción, gracias a herramientas digitales. Así podrás ir girando este escudo en 3D y disfrutar de una experiencia de construcción con los icónicos ladrillos de forma envolvente.

Otros sets de LEGO para sorprender a un fan de Marvel

* Algún precio puede haber cambiado desde la última revisión

ues de anuncios individuales.

Source link

Actualidad

Uno de los lugares más hostiles del planeta es, irónicamente, nuestro mejor “aire acondicionado” contra el efecto invernadero

Sabíamos que el Océano Austral es, en esencia, el pulmón térmico de la Tierra que es fundamental para poder regular la temperatura de todo el planeta. Pero lo que no sabíamos con exactitud era cómo lograba procesar semejante cantidad de energía. Ahora, la ciencia ha revelado que las tormentas tienen un papel protagonista que puede ser clave para hacer frente al calentamiento global.

Su utilidad. Para ponernos en contexto hay que saber que el Océano Austral tiene la capacidad de absorber más del 75% del exceso de calor que se genera por parte de las emisiones de gases de efecto invernadero que producimos los propios humanos.

Esto es algo que lo convierte en un auténtico sumidero de calor, pudiendo llegar a ser el más importante del mundo entero. De esta manera, si quitamos este Océano de la ecuación de la vida actual, la temperatura de la atmósfera a día de hoy sería mucho más elevada.

Un punto ciego. Lo tienen los propios modelos climáticos que usamos en el día a día, ya que al intentar predecir cómo se calienta el agua los cálculos no terminaba de encajar con lo que ocurría en la realidad. Claramente, aquí faltaba algún tipo de elemento que no teníamos del todo localizado.

Pero esto ha llegado a su final, gracias al equipo liderado por Marcel du Plessis y Sebastiaan Swart que han encontrado la pieza del puzzle que faltaba: la mezcla oceánica impulsada por las tormentas de verano. Un fenómeno que literalmente permite al océano ‘tragar’ el calor atmosférico.

Cómo es posible. El mecanismo que sigue este océano es tan violento como eficiente. Durante el verano austral, el sol calienta la capa superficial del océano, y si el agua se queda estancada, entonces el calor va a permanecer en la superficie almacenada en el agua, lo que facilita que vuelta a la atmósfera o acelere el deshielo. Lo correcto en este caso sería literalmente enterrarlo en las profundidades.

Y aquí es donde entran las tormentas, donde los vientos intensos y el oleaje extremo que se produce actúa como una batidora gigante. De esta manera, la energía de la tormenta agita el agua, empujando el calor de la superficie hacia las capas mucho más profundas.

Hacia la profundidad. De esta manera, las tormentas nos ayudan a que la superficie del océano se vaya enfriando, lo que le da la capacidad para seguir absorbiendo el calor del aire de una manera más eficiente.

¿Y dónde va toda esta energía? Pues literalmente, al bajar a las profundidades marinas queda ‘atrapado’ allí durante décadas, ralentizando el calentamiento atmosférico inmediato. Aunque los ojos hay que ponerlos en lo que ocurrirá en un futuro.

Cómo se ha medido. Esta es una pregunta prácticamente obligada cuando hablamos de las profundidades marinas que son lugares realmente hostiles para cualquiera. Es por ello que nuestro mejor aliado ha sido la robótica marina.

En lugar de depender de los satélites que tienen dificultades para poder ver a través de las nubes o medir la profundidad con precisión, esta tecnología trasladada a planeadores submarinos y boyas autónomas son capaces de medir la temperatura y la salinidad en tiempo real. Todo ello mientras una tormenta está pasando por encima de ellas, haciendo el fenómeno que ahora se ha estudiado.

De esta manera, esta tecnología nos ha dado la capacidad para monitorizar el océano “desde dentro” durante los eventos que son imposibles de estudiar en barcos.

Nos importa (y mucho). Este descubrimiento se puede asemejar al de una moneda con dos caras. Por un lado, ya tenemos la confirmación de que el Océano Austral es un aliado muy poderoso para poder luchar contra el cambio climático. Pero por el otro, tenemos una duda muy inquietante: ¿qué pasará si los patrones de tormentas cambian debido al propio cambio climático?

Si las tormentas se van desplazando o pierden intensidad en esta zona, podemos perder esta «esponja» de calor que está frenando el cambio climático. Las consecuencias serían bastante claras: un gran aumento de la temperatura de la atmósfera que se dejaría notar en todo el planeta.

Imágenes | jean wimmerlin Chris LeBoutillier

ues de anuncios individuales.

Source link

Actualidad

evolución y muerte de la empresa que cambió el cine y fue arrollada por su ambición

En 1939, cuando Dorothy abre la puerta de su casa transportada por el tornado y pisa por primera vez el camino de baldosas amarillas, el mundo del cine cambió para siempre. Ese momento, la transición abrupta del sepia apagado de Kansas al estallido cromático del País de Oz, no era simplemente un truco narrativo. Era una declaración tecnológica.

El amarillo dorado de ese camino, capturado por las cámaras de tres tiras de Technicolor que pesaban 227 kilos, requirió casi una semana de trabajo en MGM solo para determinar el tono exacto de amarillo. El resultado valió la pena: cada copia de ‘El mago de Oz’ que llegaba a los cines era, literalmente, una obra de arte única, gracias a los tintes transferidos manualmente, capa por capa. Un proceso tan meticuloso como complejo.

Ochenta y cinco años después, en diciembre de 2024, MPC (división de efectos visuales de Technicolor Creative Studios) entregaba otro proyecto de Disney, este sobre grandes felinos africanos: ‘Mufasa: El Rey León‘. Un equipo de más de 1.700 artistas distribuidos en cuatro continentes había trabajado durante años para crear cada brizna de hierba digital, cada pelo de la melena de Mufasa (16,9 millones de curvas capilares), cada sombra proyectada sobre las llanuras virtuales de la selva.

Dos meses después de ser nominada al Oscar a los Mejores Efectos Visuales por esa película Technicolor Creative Studios colapsaba. A nivel global, aproximadamente 10.000 profesionales veían desaparecer sus trabajos de la noche a la mañana. El Technicolor, de esta forma, ha muerto dos veces: primero gradualmente, entre 1950 y 1975, víctima de la aparición de sistemas de coloreado de celuloide más baratos y flexibles. La segunda muerte es la del conglomerado empresarial moderno que, tras múltiples metamorfosis corporativas, recogió el legado. Revisemos ambos decesos y descubramos cómo el Technicolor cambió el mundo dos veces.

Así nace el Technicolor

La historia del formato comienza en 1912, cuando Herbert T. Kalmus y Daniel F. Comstock, ambos graduados del MIT, formaron junto al mecánico W. Burton Wescott una firma de investigación industrial. Los tres ingenieros iniciaron la investigación que llevaría el color a la pantalla grande. En 1915 registraron el nombre Technicolor Motion Picture Corporation para su sociedad, como guiño a “Tech” por el MIT y “color” por la ambición que tenían de brindar colorido a las películas. Pero… ¿cómo hacerlo?

El primer sistema de Technicolor era aditivo, combinando registros de color durante la proyección para obtener color en la pantalla. La cámara usaba un divisor de haces prismático para exponer simultáneamente dos fotogramas en una sola tira de película, uno detrás de un filtro rojo y otro detrás de un filtro verde. Pero la exhibición requería un proyector especial con dos aperturas, dos lentes, y un prisma ajustable. Era poco práctico. Solo produjeron una película con este proceso, ‘The Gulf Between’, de la que hoy solo sobreviven algunos fragmentos.

El siguiente proceso que concibieron fue “sustractivo”: la información del color estaba en la propia imagen, sin necesidad de filtros, y el registro era tan bueno como el fabricante fuera capaz de poner en la película. Diseñaron una nueva cámara en 1921, de nuevo con un divisor de haces rojos y verdes, pero después del revelado, cada tira se tonificaba con un color complementario (rojo para las imágenes filtradas en verde, verde para las filtradas en rojo).

Esta tonificación reemplazaba químicamente la imagen en blanco y negro con materia colorante transparente. Las dos tiras, hechas de stock de película más delgado que el normal, se cementaban para crear una copia de proyección.

Es decir, en lugar de proyectar dos imágenes separadas de rojo y verde, el color sustractivo las combinaba en una sola copia de 35mm que podía pasar por un proyector ordinario.

Ya no se necesitaba equipo especial en los cines. Este proceso ya llegó a algunos clásicos: ‘El pirata negro’ de Douglas Fairbanks (1926), y algunas secuencias en color de superproducciones como ‘Los diez mandamientos’ (1923), ‘El fantasma de la ópera’ (1925) y ‘Ben-Hur’ (1925). Sin embargo, había problemas técnicos: de foco, de calentamiento del celuloide, vulnerabilidad extrema a los rayones, y otros. Todo ello fue resuelto poco a poco, y culminaría con la versión definitiva del Technicolor, reinvención de la cámara incluida, en 1932.

La versión definitiva

Esta nueva cámara seguía teniendo un divisor de haces consistente en una superficie parcialmente reflectante dentro de un prisma de cubo dividido, a lo que se sumaban tres tiras separadas de película de blanco y negro de 35mm. Ojo al funcionamiento: el divisor permitía que un tercio de la luz que entraba por la lente de la cámara pasara a través del reflector y un filtro verde, y formara una imagen en una de las tiras, registrando solo el tercio dominado por verde.

Los otros dos tercios de la luz se reflejaban en ángulo de 90 grados hacia otra sección de la cámara donde se encontraba con un segundo prisma, que capturaba los registros azul y rojo en dos películas empaquetadas juntas, una sensible al azul y otra al rojo, separadas por un filtro magenta. Solo llegaron a existir 30 de estas cámaras.

El proceso de revelado era no menos complejo: de los tres negativos hechos de la selección de tres colores, se obtenían tres tiras positivas, que se sometían a un proceso de curtido que endurecía la gelatina proporcionalmente, produciendo imágenes en relieve, una especie de sellos de goma microscópicos que se empapaban en tinte.

El duplicado (positivo revelado y fijado después de imprimir la pista de sonido) se ponía en contacto con estas matrices impregnadas. Todo esto era un proceso manual y cada copia era única, pero dispuesta para durar décadas si se conservaba adecuadamente (algo de lo que no podían presumir procesos posteriores como el Eastmancolor).

Ahora, los problemas: cada cámara pesaba 227 kilos porque albergaba una carcasa de gran grosor que amortiguaba el ruido del motor. Además, las producciones tempranas de Technicolor requerían una cantidad excesiva de iluminación: las temperaturas en el set de ‘El Mago de Oz’ frecuentemente excedían los 38°C y hubo problemas con los actores que cargaban con vestuario más aparatoso. En años posteriores, algunos intérpretes denunciaron haber sufrido daños oculares permanentes por los altos niveles de iluminación. La factura de electricidad de la película alcanzó, al cambio actual, unos 5 millones de dólares.

Y sobre todo, estaba el control férreo que Technicolor (la empresa) ejercía sobre Technicolor (la tecnología). Las máquinas, los técnicos que las manejaban y un “coordinador de color” que supervisaba la producción controlaban al dedillo las películas, y eso dio problemas. Por el precio, que era elevadísimo, pero también por su celo: el productor de ‘Lo que el viento se llevó0 acarició la idea de rodar en blanco y negro porque los expertos de Technicolor eran demasiado exigentes. La más famosa de estos expertos fue Natalie Kalmus, mujer de uno de los creadores del sistema y con un sueldo de 65.000 dólares (de entonces) al año.

Entre mediados de los treinta y mediados de los cincuenta está la época que se considera la gloriosa del sistema.

En 1935 se estrenó ‘La feria de la vanidad’, primer largometraje rodado enteramente con el Technicolor definitivo (significativamente, su primer director murió de neumonía, contraida por los cambios de temperatura entre sets de rodaje y exteriores, en lo que puede considerarse la primera “muerte por Technicolor”). La industria estaba en crisis en aquel momento, con todos los estudios salvo MGM atravesando problemas económicos, y el sistema fue una especie de salvavidas.

Disney abrazó el Technicolor con ‘Blancanieves y los siete enanitos’, primer largometraje animado en color. Le siguió ‘Fantasía’ en 1940, que experimentó con las posibilidades del formato en términos casi psicodélicos. ‘El Mago de Oz’ y ‘Lo que el viento se llevó’ se estrenaron con meses de diferencia.

Si recordamos que Robin Hood vestía de verde es por el color con el que se plasmó en pantalla en ‘Las aventuras de Robin Hood’ (1938). El crédito “In Glorious Technicolor” se convirtió en sello de prestigio porque, de hecho, indicaba una inversión real de mucho dinero en la película, abrazado a una estética muy concreta y asociado a grandes superproducciones donde las paletas de color estaban cuidadosamente coordinadas.

La decadencia del proceso

En 1950, mientras Hollywood celebraba su Edad de Oro en Technicolor, un pequeño equipo en los laboratorios de Eastman Kodak en Rochester trabajaba en el sistema que haría obsoleto al Technicolor no con tecnología más compleja, sino presentando una simplicidad radical. Eastmancolor, sistema patentado en 1950, eran tres capas de emulsión sensibles a diferentes colores apiladas en una sola tira de película de 35mm. Todo el espectro cromático se capturaba y revelaba en una sola película que era compatible con cualquier cámara convencional en blanco y negro.

Las ventajas eran demoledoras. Technicolor requería cámaras de 227 kilos con prismas divisores de luz, tres negativos separados, técnicos especializados y el proceso manual de transferencia de tinta. Eastmancolor funcionaba con equipos estándar y un proceso químico que cualquier laboratorio podía implementar. El costo por copia era de una fracción de lo que costaba en Technicolor. La iluminación necesaria era muchísimo menor. Y funcionaba perfectamente con los nuevos sistemas widescreen como CinemaScope, que eran incompatibles con Technicolor.

Para 1954, más del 50% de las producciones estadounidenses se rodaban en color, y la inmensa mayoría usaba Eastmancolor, rebautizado como WarnerColor, MetroColor o DeLuxe Color según el estudio que lo usara. Technicolor intentó sobrevivir pivotando a servicio de laboratorio. A partir de 1952, aceptaron negativos Eastmancolor y el crédito cambió de “Filmed in Technicolor” a “Color by Technicolor”: ya no designaba el proceso completo, solo la impresión.

Hubo, eso sí, un breve renacimiento de la tecnología entre 1997 y 2002, cuando Technicolor reintrodujo un proceso mejorado. ‘Batman y Robin’ (1997), ‘Toy Story 2‘ (1999) y ‘Pearl Harbor’ (2001) recibieron impresiones a la vieja usanza. Pero en 2001, Thomson Multimedia compró la empresa y canceló definitivamente el proceso. Las tecnologías digitales ya estaban suplantando el celuloide.

La paradoja es que las películas Eastmancolor anteriores a 1983 sufren una degradación dramática: todo se vuelve magenta, y los azules y verdes desaparecen. El mercado prefirió la conveniencia a la calidad, pero décadas después, los archivistas recurren a las copias en Technicolor.

La transformación

Pero hay una historia paralela que también implica a la marca Technicolor. Entre 1980 y 2020, la empresa experimentó una profunda transformación que modificó su naturaleza y modelo de negocio, pasando del dominio en tecnología de procesamiento de películas a convertirse en un conglomerado global centrado en efectos visuales (VFX), animación y servicios creativos para la industria audiovisual. Este cambio fue impulsado por el declive del negocio tradicional de revelado y la llegada de la era digital.

En 1982, el empresario Ronald Perelman adquirió Technicolor por 100 millones de dólares, lo que inició un período de consolidación y expansión de servicios. A mediados de los noventa, la empresa se adelantó a las tendencias futuras de la postproducción digital, ofreciendo servicios que incluían mezcla de audio, efectos visuales básicos y edición digital, intuyendo que la industria audiovisual se reorientaría hacia lo digital.

Finalmente, con la llegada del nuevo milenio, Technicolor fue adquirida por el grupo francés Thomson Multimedia en 2001, que en 2010 se renombró a Technicolor SA, haciendo honor a la histórica marca estadounidense. Entre 2004 y 2015, Technicolor impulsó una estrategia de crecimiento mediante adquisiciones: en 2004, por ejemplo, compró MPC (Moving Picture Company), un estudio británico de efectos especiales con sede en Londres valorado aproximadamente en 100 millones de dólares; en 2015 adquirió The Mill, un estudio especializado en efectos para publicidad por cerca de 300 millones de dólares.

Era una estrategia compleja, pero aparentemente con vías de tener éxito. Por ejemplo, MPC proporcionaba efectos para Warner Bros., Fox, Universal, y publicidad para Nike, Coca-Cola o Adidas. Y en 2012 ganarían el Oscar por ‘La vida de Pi’.

Sobre el papel, la estrategia tenía sentido: Technicolor construía una oferta de principio a fin, desde la pre-visualización hasta los efectos, animación, color grading y entrega final.

El mercado global de postproducción estaba valorado en alrededor de 4.000 mil millones, y los efectos representaban unos 500 millones. Sin embargo, Technicolor nunca logró integrar todas estas compras: cada estudio operaba con sus propios sistemas y clientes. Para 2020, Technicolor SA se ahogaba en deudas de más de mil millones de dólares. El 27 de septiembre de 2022, Technicolor Creative Studios se escindió como compañía independiente y en febrero de 2025, la empresa colapsó.

El cierre simbólico del ciclo de Technicolor y su legado se puede trazar desde la emblemática ‘Blancanieves y los siete enanitos’ de 1937 hasta la controvertida versión de 2025, reflejo de la transformación y las paradojas de la industria audiovisual de hoy. La primera fue un hito no sólo por ser el primer largometraje animado a color con éxito comercial, sino por demostrar el potencial revolucionario de Technicolor, con saturación y precisión de color excepcionales y una durabilidad insuperable de la imagen.

La película ha envejecido visualmente de manera extraordinaria y sigue siendo una referencia técnica y artística.

La Blancanieves de 2025 representa tanto el avance tecnológico como las limitaciones y retos actuales: refleja un entorno industrial completamente distinto, digital, fragmentado, marcado por la dependencia de complejas cadenas de realización efectos y que, simbólicamente, es un eco de la crisis estructural en la que terminó sumida Technicolor como empresa. A pesar de su brillo técnico, esta nueva ‘Blancanieves’ carece de la textura y calidez del proceso analógico original.

El destino de Technicolor ha ido de la mano de estas dos versiones ‘Blancanieves’: comenzó con la vibrante promesa del color, que elevó la narrativa audiovisual; y su desaparición en 2025 ha sido asumiendo la imposibilidad de adaptarse plenamente a esta nueva era digital. De monopolio técnico de referencia a conglomerado de efectos digitales herido de muerte por un modelo industrial demasiado complejo y tocado de muerte. O como se suele decir, solo queda esperar para ver quién es la próxima víctima.

ues de anuncios individuales.

Source link

Actualidad

irá a buscar una “Tierra 2.0” por su cuenta

China ha pisado el acelerador en soberanía espacial y ya está en velocidad de crucero: en 2025 ha batido su récord de lanzamientos de cohetes con 80 unidades a lo largo del año y solo en diciembre completó cuatro misiones espaciales. Incluso ha ejecutado con éxito una prueba estrés para constatar que pueden subir de nivel. Tanto, que ya tienen en mente explorar el espacio en busca de una Tierra 2.0.

El plan de China para encontrar una nueva Tierra. Así se llama el vídeo que la cadena china CGTN publicó hace unos días en su espacio Hot Take. En ese metraje se detallan cuatro misiones que la Administración Nacional del Espacio de China (CNSA) tiene programadas dentro del XV Plan Quinquenal del país (2026–2030) para respaldar su posición como potencia espacial de primer orden y cuyo espectro es tan amplio como vamos a ver a continuación.

Entre esas misiones se encuentra un experimento de radioastronomía para estudiar los objetos celestes mediante la medición de sus emisiones de radio, en este caso orientado a conocer mejor la cara oculta de la luna; un observatorio solar que investigará las condiciones meteorológicas como el viento solar o las tormentas geomagnéticas, la construcción de un telescopio espacial que monitorizará agujeros negros y estrellas de neutrones y un satélite cazador de planetas fuera del sistema solar. Este último tiene un objetivo ambicioso: buscar un planeta análogo a la Tierra.

Una particularidad de estas misiones es que corren a cargo de la la Academia China de las Ciencias (CAS), una institución independiente de la Agencia Espacial China y sus grandes proyectos espaciales. La CAS gestiona sus propias misiones (como HXMT o Wukong) de forma independiente y no siguen directrices gubernamentales, sino que nacen de propuestas de investigadores y universidades, siguiendo un modelo de bajo coste y flexibilidad similar al programa Discovery de la NASA.

China está buscando una Tierra 2.0 y conocer el espacio mucho mejor

Proyecto Hongmeng. Este plan pretende desplegar diez telescopios de baja frecuencia que orbitarán alrededor de la luna. Como otros observatorios centrados en su cara oculta, van a escuchar las señales de radiofrecuencia del periodo conocido como la “Edad Oscura del Universo“. Esta época corresponde a un tiempo del universo primitivo donde no había ni estrellas ni galaxias ni planetas, solo hidrógeno neutro que absorbía luz, creando oscuridad, y emitía una señal de radio característica de 21 centímetros.

¿Por qué la cara oculta de la luna? Esencialmente, porque está libre de interferencias de radio procedentes de fuentes terrestres y de las emisiones regulares del Sol. Esta misión es complementaria a otras como la del Telescopio Espacial James Webb (JWST) para estudiar esas épocas tempranas, que en la actualidad son indetectable para los telescopios convencionales.

La misión solar Kuafu-2. El dos de su nombre ya desvela algo: hubo un Kuafu-1 lanzado en 2022 y también conocido como Observatorio Solar Avanzado basado en el Espacio (ASO-S). El primero se lanzó para estudiar el campo magnético del sol y sus fenómenos, como las liberaciones súbitas e intensas de radiación electromagnética (fulguraciones) o las eyecciones de masa coronal.

Pero Kuafu-2 irá un paso más allá: será el primer satélite en orbitar las zonas de difícil acceso orbital del Sol, las regiones polares, proporcionando así datos sobre el campo magnético solar y la dinámica del ciclo solar (que dura aproximadamente 11 años). Con esta información, el equipo científico espera poder predecir tormentas solares y sus efectos en cascada por todo el sistema solar.

A la busca de un planeta análogo a la Tierra. El Exo-Earth es un satélite de prospección de exoplanetas que el programa ha definido como un “detective planetario en una misión para ver si la Tierra es única en su especie”. Su objetivo será monitorizar miles de estrellas de nuestra galaxia en busca de planetas rocosos de un tamaño comparable al de la Tierra que orbiten dentro de la zona de habitabilidad de sus estrellas, es decir, a una distancia suficiente para que pueda existir agua líquida en su superficie. Un análogo a la Tierra. Este observatorio se lanzará en 2028.

¿Cómo funcionan las leyes de la física ahí fuera?. El cuarto y último es el Observatorio mejorado de Temporización y Polarimetría de rayos X, un proyecto internacional liderado por el gigante chino que combina observaciones de rayos X con una “capacidad de temporización y polarimetría sin precedentes”. O lo que es lo mismo, la medición ultraprecisa de las variaciones de brillo en el tiempo y el estudio de la orientación de las oscilaciones de las ondas electromagnéticas para inferir la geometría de los campos magnéticos.

Si suena denso y científico es porque lo es: sirve para saber cómo aplican las leyes de la física en entornos tan extremos como alrededor de agujeros negros, estrellas de neutrones, supernovas y otros objetos astrofísicos. Su propuesta técnica detalla que este observatorio contará con avanzados sistemas de enfoque espectroscópico y sistemas de enfoque polarimétrico. El lanzamiento está previsto para 2030.

Imagen | Xinhua

Provided by Universe Today

ues de anuncios individuales.

Source link

-

Actualidad2 días ago

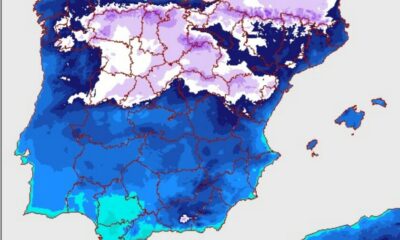

Actualidad2 días agoun temporal que apunta a dejar bajo la nieve la noche de Reyes

-

Musica2 días ago

Musica2 días agoMTV: Estos fueron los últimos videos que transmitió el canal de televisión

-

Tecnologia2 días ago

Tecnologia2 días agoDenuncian en X el uso de la IA para crear imágenes sin consentimiento de las personas

-

Actualidad1 día ago

Actualidad1 día agolos tres ganadores mientras la electrificación gana peso

-

Musica2 días ago

Conciertos: La música se apodera del calendario en Guadalajara

-

Actualidad2 días ago

Actualidad2 días agoDurante años hemos visto a delfines nadar hacia las orcas sin miedo. Ahora la tecnología ha averiguado por qué

-

Actualidad2 días ago

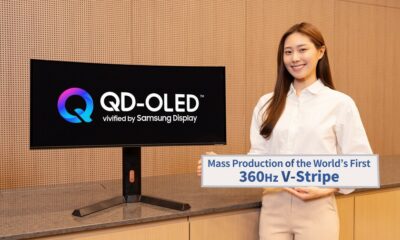

Actualidad2 días agoLos nuevos monitores QD-OLED de Samsung estrenan píxeles verticales para ir más allá del gaming: quieren reinar en las oficinas

-

Actualidad22 horas ago

Actualidad22 horas agoLlevamos décadas fracasando con los propósitos de año nuevo. La ciencia dice que es porque no sabemos “hacer trampas”