Escrito en ENTRETENIMIENTO el

Actualidad

La industria del PC está dejando de lado al usuario no-gamer. Sobre todo si hablamos de monitores

En la industria de los periféricos de PC hay un sector especialmente mimado: el del gaming. Es a este tipo de usuarios a los que los fabricantes suelen dedicar sus desarrollos más ambiciosos, quizás a sabiendas de que hoy en día dichos usuarios están especialmente dispuestos a invertir en esos periféricos.

El problema es que en muchos casos eso deja un poco huérfanos a los usuarios que no juegan o solo lo hacen de forma ocasional. Hay desde luego categorías de periféricos muy bien cubiertas para entornos gaming y no-gaming, pero hay uno en especial que no: el de los monitores.

Si eres gamer, todo es felicidad

Los amantes de los buenos ratones y teclados, por ejemplo, tienen a su disposición una cantidad espectacular de opciones, tanto si son gamers como si no lo son. La especialización aquí es espectacular, y lo estamos viendo desde luego en el apasionante mundo de los teclados, especialmente animado en los últimos años gracias al auge de los teclados mecánicos y algunos competidores recientes.

Pero las cosas no están igual de animadas en el mundo de los monitores para quienes no son gamers. Si eres gamer la oferta es impresionante, y la calidad, formato, resolución y sobre todo tasa de refresco de estos modelos no para de dar más opciones a los gamers.

Sin embargo para los que sobre todo nos dedicamos a leer (¡y escribir!), la oferta de monitores es menos llamativa de lo que uno esperaría a estas alturas. Hace meses ya hablamos aquí de lo que para mí sigue siendo inexplicable: parece que los fabricantes no tienen ganas de innovar y nos hemos quedado estancados en la resolución 4K como estándar aceptado.

Buscando el monitor perfecto en el que sobre todo leer y escribir

Pero es que hay vida más allá de la resolución 4K. Yo llevo años usando un monitor Dell UP2715K con resolución 5K y precisamente por eso me resulta difícil —imposible— entender cómo esa resolución no se ha masificado. La mayoría de los monitores 5K disponibles adoptan una diagonal de 27 pulgadas, pero precisamente esa diagonal hace que a no ser que uno tenga vista de halcón sea imposible trabajar a resolución nativa. Pero es que eso no importa.

Sobre todo, porque estos monitores están pensados para funcionar a una resolución escalada de forma que en lugar de la resolución nativa (5.120 x 2.880) trabajes con un cuarto de esa resolución (la mitad por dimensión) de resolución efectiva, lo que resulta en un área de trabajo de 2.560 x 1.440 píxeles. Con eso logras dos cosas.

La primera, algo importante: poder leer lo que pone en pantalla :). Lo segundo, que la definición de cada píxel “se cuadruplique” gracias a ese escalado, por lo que la calidad de textos y elementos visuales sea espectacular. Como dije entonces y digo ahora, es como trabajar sobre una pegatina: todo se ve con una calidad superior a la de monitores 1440p nativos, y también a la de monitores 4K, al menos según mi punto de vista.

Dell U3224KB 6K.

Pero hay aquí margen de mejora. Lo demostró Apple con su Pro Display XDR de 32 pulgadas con resolución 6K que sería mi gran opción si no fuera porque cuesta 5.499 euros (sin el soporte Pro Stand de 1.099 euros, recordemos).

Dell tiene una propuesta similar con su Dell UltraSharp 32 6k U3224KB, y de hecho es más de dos veces más barata (2.400 euros, soporte incluido), pero la pregunta que me hago es: ¿ya está? ¿Quienes trabajamos con el ordenador 8 o 10 horas al día solo tenemos dos opciones de este tipo, y las dos a estos precios estratosféricos?

Samsung Odyssey G9. Inmenso.

Eso parece. Hay desde luego algunas opciones interesantes: los monitores ultrapanorámicos —no necesariamente gamers— permiten disfrutar de espacios de trabajo extendidos muy interesantes para quienes necesitan esas grandes horizontales.

Aquí hay formatos sencillamente arrebatadores como los de los Samsung Odyssey G9 que a mí, la verdad, me parecieron demasiado ultrapanorámicos: trabajar en ellos era como ver un partido de tenis. Prefiero ultrapanorámicos menos ultrapanorámicos (34-40 pulgadas) pero desde luego la propuesta de Samsung es espectacular y seguramente sí tenga sentido para muchos usuarios.

Los monitores BenQ RD especialmente pensados para desarrolladores adoptan un formato 3:2 y apuestan por trabajar con una única ventana maximizada en pantalla todo el tiempo.

Durante cierto tiempo incluso pareció que los monitores con el singular formato 3:2 iba a despegar. El Huawei Mateview nos quería demostrar que trabajar con una sola ventana en pantalla era perfecto para no distraerse, y aunque ha habido algunos modelos más —los BenQ RD para programadores—, este tipo de decisión de diseño ha tenido una acogida muy modesta.

Usar una televisión OLED como monitor también parecía ser una posibilidad llamativa. Yo mismo me planteé cambiar mi Dell 5K por una tele de mayor formato en la que trabajar en resolución 4K de forma nativa.

LG C2. Parecía que sí, pero no.

La LG C2 de 42 pulgadas parecía perfecta para eso, pero descubrí que los fabricantes de televisores, por muy bien que lo hagan en ese apartado, no preparan sus productos para ser utilizados como monitores. La definición del texto era aquí claramente peor que en mi monitor 5K, pero diría que también era peor que en monitores 4K o 1440p, por ejemplo. A pesar de sus ventajas en otros ámbitos —multimedia, incluso videojuegos—, usar una televisión con panel OLED para trabajar leyendo y escribiendo no me pareció la mejor experiencia.

Hay otra eterna promesa: la de los monitores con pantallas de tinta electrónica. Parecen un producto fantástico para quienes nos pasamos el día leyendo —menos impacto en la visión— y podrían ser unos compañeros fantásticos incluso al escribir también, pero las tasas de refresco y la ausencia de color los hacen demasiado específicos: no poder disfrutar de la riqueza visual de la web, imágenes y vídeos incluidos, es perderse buena parte de la experiencia.

Aun así, plantean una opción interesante en entornos multimonitor: combinar un monitor con pantalla de tinta electrónica con uno “convencional” parece desde luego algo atractivo, como muestra la imagen. Algunos fabricantes exploraron esa opción con valentía, aunque no parece que la idea cuajara. Lo que está claro es que no hay demasiado movimiento en el mercado en este sentido.

Estamos pues ante una situación en la que los fabricantes no parecen querer arriesgar demasiado. Aunque se presentan nuevos modelos, no hay apenas apuestas que planteen monitores de mayor resolución e incluso tasas de refresco, pero pensados sobre todo para leer y escribir.

No existen monitores 5K con tasas de refresco de 120 Hz (que no sean ultrapanorámicos, me refiero), por ejemplo, a pesar de que los estándares HDMI y DisplayPort ya son capaces de soportar tales configuraciones. La tasa de refresco no es tan importante al leer o escribir como al jugar a videojuegos, pero quien usa monitores gaming para trabajar sabe que esas altas tasas de refresco también son bienvenidas al navegar por internet o realizar cualquier tarea. Son más agradables a los ojos, simplemente.

Quizás los fabricantes acaben dándose cuenta de que hay una oportunidad aquí. Una para dar el salto masivo a monitores de 32 pulgadas 6K, pero también para descubrirnos otras posibilidades que permitan hacer lo que hacemos tantas horas del día —leer y escribir—, pero hacerlo aún mejor.

ues de anuncios individuales.

Source link

Actualidad

De la música al cine: Residente debutará como director con una película protagonizada por Bad Bunny

EFE.- El artista puertorriqueño René Pérez Joglar (Residente) debutará como director de largometrajes con el drama histórico épico “Porto Rico”, protagonizado por su colega Bad Bunny y con un elenco que incluye a actores de la talla de Viggo Mortensen, Edward Norton y Javier Bardem.

“He soñado con hacer una película sobre mi país desde que era niño. La verdadera historia de Puerto Rico siempre ha estado rodeada de controversia”, afirmó en un comunicado este miércoles Residente, ganador de 34 premios Grammy y Latin Grammy, que ha desarrollado también una carrera como actor en “In the Summers” y “Frank & Louis”.

‘Porto Rico’, coescrita entre Residente y el guionista ganador del premio Óscar Alexander Dinelaris (“Birdman”), es un western caribeño inspirado en hecho reales que aborda la compleja historia colonial de Puerto Rico a través de una mirada visualmente intensa.

“Esta película es una reafirmación de quiénes somos, contada con la intensidad y la honestidad que nuestra historia merece“, comentó el artista sobre este filme centrado en los orígenes de su isla natal.

Benito Martínez Ocasio (Bad Bunny), quien recientemente hizo historia al ganar el Grammy al Mejor Álbum del Año con el disco en español “Debí tirar más fotos”, tiene en este largometraje su primer papel protagónico en cine, después de su participación en cintas como “Bullet Train” y “Caught Stealing”.

Lo acompañan Mortensen (“Eastern Promises”, “Captain Fantastic”, “Green Book”), Norton (“American History X”, “Birdman”, “A Complete Unknown”) y el español Bardem (“No Country for Old Men”), con más integrantes del elenco por anunciar.

Residente y Erick Douât producen a través de 1868 Studios, mientras que Norton y Bill Migliore, junto a Michael Bederman, producen para Class 5 Films.

“Esta película se inscribe en una tradición de filmes que amamos profundamente, desde ‘The Godfather’ hasta ‘Gangs of New York’, que nos impactan con un drama visceral y personajes y épocas icónicas, pero que también nos obligan a confrontar la historia en la sombra que subyace bajo la narrativa estadounidense del idealismo”, explicó Norton.

“Todo el mundo conoce a René como un poeta del lenguaje y el ritmo. Ahora también verán al visionario visual que es. Y reunirlo con Bad Bunny para contar la verdadera historia de las raíces de Puerto Rico será como una llama encontrando el cartucho de dinamita que la estaba esperando”, subrayó.

Puerto Rico fue colonia española hasta 1898, cuando pasó a manos de Estados Unidos tras la guerra hispano-estadounidense. En la actualidad, la isla es un Estado Libre Asociado a Estados Unidos.

El director ganador de múltiples premios Óscar Alejandro G. Iñárritu se desempeña como productor ejecutivo junto a Scott Budnick y su sello 1Community, Mike Novogratz, Sukey Novogratz, José E. Feliciano, Kwanza Jones, Henry R. Muñoz III y Noah Assad. UTA Independent Film Group representa las ventas internacionales.

1868 Studios, creada a través de una alianza estratégica de varios años entre Residente, Sony Music Latin-Iberia y Sony Music Vision, está comprometida con elevar la cultura latina y llevar historias latinas a audiencias globales a través de sus proyectos.

ues de anuncios individuales.

Source link

Actualidad

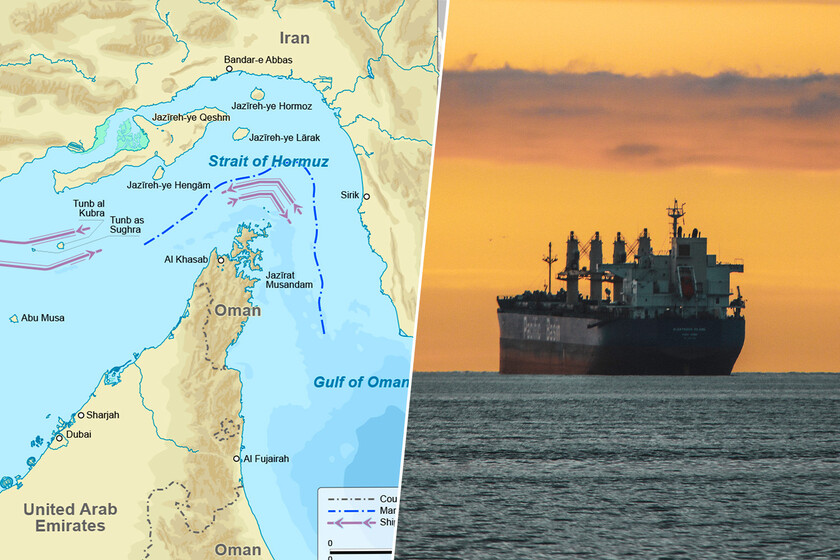

La tensión en Irán es tan alta que el estrecho de Ormuz está cerrado. Y eso va a tener consecuencias cuando vayas a repostar

El mundo amaneció hoy con una contradicción peligrosa: mientras en los asépticos salones de Ginebra los diplomáticos de Estados Unidos e Irán se estrechan la mano con cautela, en las aguas del Golfo Pérsico las lanchas rápidas de la Guardia Revolucionaria bloquean el paso a los petroleros. No hace falta que caiga un misil para que la economía global sienta el impacto; el miedo cotiza al alza y viaja más rápido que cualquier buque.

El Estrecho de Ormuz, la yugular energética del planeta, ha sufrido un cierre “parcial y temporal” por primera vez desde que la tensión escaló en enero. Para el consumidor, esto no es un titular lejano: el precio del petróleo Brent acumula ya una subida del 13% en lo que va de año. Un encarecimiento que no responde a una falta real de suministro, sino a la prima de riesgo geopolítica. Estamos pagando por lo que podría pasar, no por lo que ha pasado.

Según confirmaron medios estatales iraníes citados por Euronews, Teherán ordenó el cierre parcial del Estrecho de Ormuz bajo la justificación de “precauciones de seguridad”. La agencia de noticias iraní Fars, referenciada por Deutsche Welle, detalló que esta maniobra responde a los ejercicios militares bautizados como “Control Inteligente del Estrecho de Ormuz”. Es un movimiento inédito en esta crisis: es la primera vez que Irán cierra físicamente sectores de la vía fluvial desde que la administración estadounidense amenazó con acciones militares el pasado enero.

Sin embargo, es importante matizar el alcance operativo para no caer en el alarmismo injustificado. Jakob Larsen, director de seguridad de Bimco (la asociación que representa a los armadores mundiales), explicó a la CNBC que no se trata de un bloqueo total indefinido. El cierre afecta al área del “esquema de separación de tráfico” entrante y dura “varias horas”. Las autoridades iraníes han solicitado a los buques comerciales que se mantengan alejados de la zona de ejercicios, lo que está provocando retrasos y “molestias menores”, pero el flujo no se ha detenido por completo.

Un embudo de 33 kilómetros para el 20% del petróleo mundial

Para entender por qué el mercado contiene la respiración, hay que mirar el mapa. La Administración de Información Energética de Estados Unidos (EIA) califica este paso como el “punto de estrangulamiento” (chokepoint) más importante del mundo para el tránsito de petróleo.

Las cifras son contundentes:

- Volumen: Por esta arteria fluyen diariamente unos 20 millones de barriles de crudo, condensados y productos refinados.

- Impacto Global: Según datos de las consultoras Vortexa y Kpler, esto representa aproximadamente el 20% del consumo mundial de líquidos derivados del petróleo y cerca del 30% del comercio marítimo de crudo.

El problema es geográfico. Como explica DW, en su punto más angosto, la vía tiene apenas 33 kilómetros de ancho. Pero lo crucial es que la ruta navegable segura para los grandes superpetroleros es de solo dos millas de ancho en cada dirección. Es un embudo perfecto donde cualquier interrupción, por pequeña que sea, genera un efecto dominó inmediato.

El timing de esta operación militar no es una coincidencia; es un mensaje. Según analiza Euronews, el cierre parcial se produjo exactamente mientras se celebraba en Ginebra la segunda ronda de conversaciones nucleares entre Abbas Araghchi, ministro de Exteriores iraní, y Steve Witkoff, enviado especial de Estados Unidos. Por ese motivo, Teherán está utilizando el estrecho como palanca de negociación. Estados Unidos ha incrementado su presión militar con el despliegue del portaaviones USS Gerald R. Ford en la región, en respuesta tanto a las ambiciones nucleares de Irán como a la sangrienta represión de las protestas internas que sacuden al país persa.

Paradójicamente, la diplomacia parece avanzar mientras los cañones apuntan. Según Reuters, Araghchi confirmó tras la reunión que se ha alcanzado un “principio de acuerdo” sobre las bases de una futura relación, aunque advirtió que cerrar el pacto definitivo será un proceso lento. Irán muestra el puño en el mar mientras ofrece la mano en Suiza.

El espejismo de los precios: ¿por qué pagamos la “prima de miedo”?

La reacción de los mercados ha sido una montaña rusa emocional en las últimas 24 horas:

- El espejismo del martes: Inicialmente, al conocerse los avances en Ginebra, el precio del petróleo cayó. El barril de Brent bajó un 1,8% (hasta los 67,36 dólares) y el West Texas Intermediate (WTI) cedió un 1%. Los mercados “compraron” la esperanza de paz.

- La realidad de hoy miércoles: La tendencia se ha revertido. Los precios se están recuperando y vuelven a subir. Como explican en OilPrice, los traders han reevaluado la situación: el acuerdo final se ve lejano y el cierre físico del estrecho, aunque parcial, es una realidad tangible hoy.

Tal y como señala Sugandha Sachdeva, analista citada por Reuters, el mercado está experimentando un “repunte técnico” porque la duda domina el escenario. Aunque el 82% del crudo que pasa por Ormuz va a Asia (China, India, Japón), el petróleo es un mercado global. Si falta oferta en Asia, esos países pujarán por el crudo disponible en otras regiones, encareciendo el barril para todos.

Esto tiene un efecto inmediato en Europa debido a la “financiarización” de la energía. El gas y el petróleo han dejado de ser simples commodities para convertirse en activos financieros que operan con algoritmos de alta velocidad. La volatilidad es tal que “un titular de madrugada sobre Irán puede alterar el precio de la calefacción en Berlín antes de que amanezca”.

El talón de Aquiles europeo

La situación es especialmente delicada para el Viejo Continente. Europa vive un “doloroso déjà vu“: al huir de la dependencia rusa, ha caído en la dependencia del gas que llega por barco (GNL). Las reservas europeas de gas están en mínimos preocupantes (al 44% a finales de enero) y la vulnerabilidad es máxima.

Aquí es donde Ormuz juega un papel crítico más allá del petróleo. Como hemos detallado en Xataka, la Unión Europea mira hacia Qatar como alternativa vital para su suministro de gas, pero “las tensiones militares entre EEUU e Irán en el Estrecho de Ormuz ponen en riesgo esa ruta”. Si se cierra el estrecho, no solo se bloquea el petróleo a Asia, sino también el gas natural licuado qatarí que Europa necesita desesperadamente para rellenar sus almacenes de cara al próximo invierno.

El horizonte a corto plazo es sombrío. Según una estimación de Eurasia Group recogida por OilPrice, existe un 65% de probabilidades de que Estados Unidos lance un ataque militar contra Irán en abril si las conversaciones actuales fracasan. Por su parte, Irán no parece dispuesto a ceder en su retórica. El almirante Alireza Tangsiri, comandante de la Armada de la Guardia Revolucionaria, declaró sin ambages a la televisión estatal: “Estamos listos para cerrar el estrecho cuando nuestras autoridades lo ordenen”.

Sin Plan B: por qué cerrar el grifo sería un suicidio económico

Es fundamental añadir un matiz de experto que a menudo se pasa por alto: cerrar Ormuz completamente sería un arma de doble filo, o incluso un “suicidio económico” para Irán. Analista de JPMorgan, citados por Reuters, señalan que la economía iraní depende del libre tránsito por esa vía. “Cortar el Estrecho de Ormuz sería contraproducente para la relación de Irán con su único cliente petrolero actual: China”, explican los expertos.

¿Existen alternativas si el cierre se vuelve total? Pocas y limitadas.

- Arabia Saudita opera el oleoducto Este-Oeste.

- Emiratos Árabes Unidos cuentan con una conexión hacia Fujairah, en el Golfo de Omán.

- Sin embargo, la EIA estima que estas rutas alternativas solo tienen capacidad para desviar unos 2,6 millones de barriles diarios de los 20 millones que transitan habitualmente. El mundo no tiene un “Plan B” real para sustituir a Ormuz.

El Estrecho de Ormuz ha dejado de ser solo una línea estratégica en los mapas militares para convertirse en el termómetro del miedo global. Lo que ha ocurrido esta semana es un aviso: la vía se ha cerrado “parcialmente” y el mercado ha temblado.

Si la diplomacia que ahora se teje en Ginebra fracasa y ese 65% de probabilidad de conflicto bélico se materializa, el encarecimiento del 13% que hemos visto este año en el petróleo podría parecer una anécdota menor. La estabilidad de nuestra factura de la luz, paradójicamente, se está jugando hoy en unas coordenadas lejanas, entre lanchas rápidas y destructores, en las aguas calientes de Oriente Medio.

Imagen | Goran_tek-es y Freepik

ues de anuncios individuales.

Source link

Actualidad

ahora pueden hundir cualquier cosa, incluso islas

Lo hemos ido contando: China ha transformado su poder naval lejos de los focos más visibles durante años, avanzando de forma constante en tecnologías que priorizan el sigilo, la persistencia y la capacidad de negar el acceso al adversario. Mientras la atención internacional se centraba en portaaviones y grandes buques de superficie, bajo el mar se ha ido gestando una evolución silenciosa que ahora apunta a un cambio profundo en la forma de proyectar fuerza y resolver conflictos.

El arma inesperada. Sí, lejos de la idea clásico de portaaviones o bombarderos estratégicos, el último gran salto de China en la guerra naval no ha llegado desde las plataformas más visibles, sino desde sus submarinos convencionales, discretos y hasta ahora considerados secundarios frente al poder nuclear.

La incorporación del misil hipersónico antibuque YJ-19 a los submarinos diésel-eléctricos con propulsión independiente del aire ha convertido a estas unidades “ordinarias” en una amenaza capaz de cambiar las reglas del juego, al combinar sigilo extremo con una capacidad de ataque diseñada para superar las defensas navales más avanzadas y proyectar poder letal sin previo aviso.

De submarino convencional a cazador hipersónico. El misil YJ-19, presentado públicamente en 2025 y ahora aceptado para el servicio operativo, supone un salto cualitativo respecto al anterior YJ-18 al elevar la velocidad del ataque hasta el umbral hipersónico o, dicho de otra forma, ha multiplicado la dificultad de detección e interceptación.

Integrado en los Type-039B de la clase Yuan, columna vertebral de la flota submarina convencional china, este misil transforma a estos buques en los únicos submarinos no nucleares del mundo armados con un sistema de este tipo, un movimiento que refuerza de forma radical la capacidad de negación marítima de la Armada del Ejército Popular de Liberación y sitúa a su flota AIP en una liga propia dentro del equilibrio naval global.

La ventaja silenciosa de los tubos lanzatorpedos. La clave técnica que explica el carácter disruptivo de los misiles YJ-19 no está solo en su velocidad, obvio, sino en su compatibilidad con tubos lanzatorpedos horizontales estándar de 533 milímetros, una habilidad que permite modernizar submarinos existentes sin prácticamente tener que recurrir a complejos sistemas de lanzamiento vertical.

Esta decisión permite ahorrar costes, ya que abarata, acelera y masifica su despliegue, permitiendo, por ejemplo, que una flota numerosa de submarinos silenciosos pueda lanzar ataques hipersónicos desde posiciones ocultas, algo que otras potencias no pueden replicar fácilmente con sus submarinos convencionales.

Una flota convencional como arma estratégica. Es otra de las patas que surge tras el movimiento. Gracias a la propulsión AIP, los Yuan pueden permanecer sumergidos durante largos periodos a baja velocidad, lo que permite reducir su señal acústica y poder operar en aguas litorales o zonas de acceso restringido.

Por tanto, armados ahora con misiles diseñados específicamente para perforar defensas navales modernas, estos submarinos han dejado de ser simples plataformas tácticas para convertirse en auténticos multiplicadores estratégicos, capaces de amenazar grupos de combate enteros y de imponer costes inasumibles a cualquier fuerza naval que opere cerca de las costas chinas.

Taiwán en el fondo. La última lectura del avance es posiblemente la más obvia en clave futura. Si Pekín decidiera avanzar hacia un conflicto abierto en torno a la isla de Taiwán, la incorporación del YJ-19 a submarinos AIP tendría implicaciones profundas: permitiría establecer un cerco marítimo letal sin necesidad de exponer grandes unidades de superficie, dificultando la intervención de flotas aliadas y elevando el riesgo para cualquier intento de romper un bloqueo.

De esta forma, los submarinos silenciosos, dispersos y armados con misiles hipersónicos, podrían atacar buques, infraestructuras portuarias o incluso líneas de suministro con escaso margen de reacción, convirtiendo el mar que rodea la isla en un entorno extremadamente hostil y reforzando la estrategia china de negación de área desde la sombra.

Imagen | CCTV, SteKrueBe

En Xataka | Imágenes satelitales no dejan lugar a dudas: el renacimiento nuclear de China ya es visible desde el espacio

En Xataka | Los cazas chinos están aproximándose peligrosamente a los F-16 de Taiwán. Y les están “disparando” bengalas

ues de anuncios individuales.

Source link

-

Actualidad2 días ago

Actualidad2 días agolos plazos ya no cuentan igual

-

Actualidad16 horas ago

Actualidad16 horas agoPablo Isla se ha convertido en el “arreglatodo” de las multinacionales europeas

-

Musica2 días ago

Musica2 días agoConciertos en Guadalajara: Cartelera del 16 al 22 de febrero

-

Musica21 horas ago

Tequila: Ben Böhmer, Tripolism y Zombies in Miami encabezan el ritual electrónico de Akamba 2026

-

Musica2 días ago

Musica2 días agoShakira celebra el éxito total con “Las Mujeres Ya No Lloran”

-

Musica17 horas ago

Musica17 horas agoAkamba 2026 revela lineup: Mochakk y más llegan a Tequila

-

Actualidad22 horas ago

Actualidad22 horas agoJapón lleva años deseando tener menos turistas. Ahora teme que China esté haciendo sus deseos realidad

-

Actualidad2 días ago

Actualidad2 días agoChina llevó robots humanoides al mayor espectáculo televisivo del país: los hizo practicar kung-fu con precisión milimétrica